Warum Ihr Unternehmen Kubernetes nutzen sollte – oder eben nicht

Über Kubernetes wird im Bereich der Serververwaltung am häufigsten diskutiert. Doch wann und wie sollte man es einsetzen? Finden Sie es hier heraus!

In dem modernen Softwareentwicklungsprozess ist die Containerisierung neuer Anwendungen mittlerweile üblich. Ein Container erstellt eine isolierte Umgebung auf einem Computer und installiert nur das, was für den Betrieb der Anwendung erforderlich ist. Dadurch kann eine Anwendung unabhängig von der zugrunde liegenden Hardware ausgeführt werden, solange die erforderlichen Rechenkapazitäten vorhanden sind. Dies ermöglicht eine Mikroumgebung für Anwendungen und minimiert das Risiko unerwarteter Fehler.

Doch je komplexer Anwendungen werden und je stärker sie in mehrere Microservices unterteilt sind, desto schwieriger wird die Verwaltung dieser zahlreichen Container. Einige Unternehmen betreiben Hunderte von Containern gleichzeitig – mit unterschiedlichen Anforderungen an Ressourcen und Nutzung. Auch diese Prozesse müssen effizient orchestriert werden. In diesem Kontext erweist sich Kubernetes (kurz K8S) als die Top-Lösung zur Unterstützung und Koordination mehrerer Container gleichzeitig. Kubernetes erkennt Fehler, repliziert stark beanspruchte Container und sorgt für eine effiziente Lastverteilung. In diesem Artikel erläutern wir, wie dieses leistungsstarke Tool funktioniert und welche Vorteile es für die Performance und Ausfallsicherheit Ihrer IT-Services bringen kann.

Inhaltsverzeichnis

- WWas ist Kubernetes?

- Erfolgsbeispiele auf dem Markt

- Warum und wann sollte man Kubernetes nutzen?

- Wie fängt man mit Kubernetes an?

- Fazit

Was ist Kubernetes?

Kubernetes ist eine Open-Source-Software (FOSS), die ursprünglich 2014 von Google entwickelt wurde und seit 2015 von der Cloud Native Computing Foundation (CNCF) verwaltet wird. Es dient der Orchestrierung und Verwaltung zahlreicher Container und bietet eine ausfallsichere, effizientere Systemsteuerung. Kubernetes kann automatisch die Größe von Clustern skalieren, verschiedene operative Aufgaben erledigen und die Verwaltung komplexer Containerlandschaften erheblich vereinfachen.

Die grundlegende Architektur von Kubernetes basiert auf Pods, Nodes und Clustern, die durch eine Steuerungsebene (Control Plane) verwaltet werden. Ein Pod, die kleinste ausführbare Einheit des Servers, kapselt einen oder mehrere Container. Obwohl ein Pod mehr als einen Container ausführen kann, ist dies selten der Fall und wird nur verwendet, wenn mehrere Container aufeinander angewiesen sind.

Eine Node hingegen sind die physischen oder virtuellen Maschinen, auf denen Pods mit Kubelet, Kube-Proxy und mit Hilfe der Container-Laufzeitumgebung ausgeführt werden. Ein Cluster enthält verschiedene Nodes, abstrahiert einzelne Maschinen und ermöglicht die verteilte Ausführung der Workloads.

Er besteht aus zwei Hauptelementen: der Steuerungsebene (Control Plane) und den Worker-Nodes. Die Steuerungsebene ist ein YAML- oder JSON-Dokument, das den gewünschten Zustand des Clusters beschreibt, einschließlich der auszuführenden Pods und deren Speicherorte. Sie ist der Schlüssel zu einem der größten Vorteile von Kubernetes: es ist herstellerunabhängig, d.h. es kann auf jedem Server ausgeführt und aufgrund dieses YAML-Plans problemlos von einem zum anderen verschoben werden. Die Worker-Nodes sind die Einheiten, die für die Ausführung der tatsächlichen Workloads zuständig sind.

Auf diese Weise bietet Kubernetes eine klar definierte Hierarchie, innerhalb derer der Server ausgeführt wird. Die Struktur aus Clustern, Nodes und Pods ist entscheidend für die Autoskalierung, da Pods bei hoher Nachfrage automatisch repliziert werden. Zusätzlich zum Replikationsprozess führt Kubernetes einen Load Balancer aus, und falls einer dieser Pods ausfällt, werden sie automatisch vom Controller Manager neu erstellt.

Erfolgsbeispiele auf dem Markt

Da Kubernetes inzwischen zum Standard für Unternehmen mit großen Produkten geworden ist, die von Tausenden oder sogar Millionen von Nutzern verwendet werden, gibt es viele Erfolgsbeispiele auf dem Markt. Es ist heute fast unvorstellbar, Anwendungen, die riesige Datenmengen verarbeiten, ohne Kubernetes zu betreiben – Unternehmen wie Google, Spotify, AirBnB und andere verwenden es.

So zeigt beispielsweise eine von EarthWeb durchgeführte Studie, dass 76 % aller globalen Internetrecherchen auf Google durchgeführt werden, mit einem globalen Durchschnitt von rund 6,3 Milliarden Suchanfragen pro Minute. Das ist eine enorme Datenmenge, und diese muss mittlerweile sogar von KI verarbeitet werden, bevor das Endergebnis geliefert wird, was die Infrastruktur zusätzlich verkompliziert. Ihre Services müssen also zu 100 % verfügbar sein, da jeder einzelne Ausfall massive Schäden auf der ganzen Welt verursachen könnte. Um diese Nachfrage zu bedienen, müssen ihre Server repliziert und ihre Container parallelisiert werden, und das ist es, was Kubernetes für sie tut.

Was AirBnB betrifft, so zeigt eine von The Stack durchgeführte Studie, dass ihre Struktur zuvor in Tausende von Clustern unterteilt war, die auf Hunderte von Nodes verteilt waren. Allerdings stiegen laut Berichten aus dem Jahr 2021 die Cloud-Kosten schneller als die Einnahmen. Deshalb setzte sich das Unternehmen das Ziel, die Kosten pro gebuchter Nacht zu senken. Diese große Infrastruktur wurde manuell verwaltet, was weitgehend unpraktisch war, da die Größe des Nodes nicht manuell geändert werden konnte, was zu unnötigen Ausgaben führte. Sie migrierten ihre Cluster dann in eine Kubernetes-Umgebung, die sich je nach Bedarf automatisch skalierte. Allein dadurch konnten sie ihre Cloud-Kosten um 5 % senken und den Aufwand für die manuelle Verwaltung der Clustergröße eliminieren.

Auch Spotify setzte früh auf Kubernetes, führte die Technologie jedoch schrittweise ein. Eine auf dem Kubernetes-Blog veröffentlichte Studie zeigt, dass dieser Prozess mehrere Jahre dauerte. Mit der Implementierung von Kubernetes konnten jedoch das Bin-Packing-Verfahren und die Multi-Tenancy-Funktion die durchschnittliche CPU-Auslastung zwei- bis dreimal steigern. Zudem beschleunigte Kubernetes die Bereitstellung neuer Services, sodass sich das Unternehmen stärker auf neue Funktionen und Leistungsverbesserungen konzentrieren konnte.

Diese Beispiele zeigen, wie wichtig Kubernetes für die Reduzierung der Wartungskosten für Cloud-Anwendungen sein kann. Durch die automatische Verwaltung von Node-Größen können Unternehmen Tausende Dollar ersparen – und das ist erst der Anfang. Kubernetes bietet noch viele weitere Optimierungsmöglichkeiten, um Ressourcen effizienter an spezifische Anforderungen anzupassen.

Warum und wann sollte man Kubernetes nutzen?

Trotz all der genannten Vorteile passt Kubernetes nicht für jede Anwendung. Es eignet sich für sehr spezifische Anwendungsfälle und ist für einfache Apps mit kleinem Infrastrukturbedarf oft überdimensioniert. In solchen Fällen kann der Einsatz von Kubernetes die Architektur unnötig verkomplizieren und die Kosten sowie den technischen Aufwand nicht rechtfertigen. Kubernetes entfaltet sein volles Potenzial in stark frequentierten Umgebungen, in denen viele Nodes und Cluster zur Skalierung benötigt werden.

Daher ist Kubernetes empfehlenswert, wenn Ihr Unternehmen viele Microservices nutzt oder Ihre Cloud-Kosten zu hoch sind. Ein klassisches Beispiel wäre ein SaaS, bei dem die Nachfrage plötzlich stark ansteigt und die Server überlastet sind. In solchen Fällen sollte die Cluster-Größe automatisch verwaltet werden, um Leistungseinbußen bei hoher Nachfrage zu vermeiden und gleichzeitig Kosten zu senken, wenn die Auslastung zurückgeht. Dies ist ein klarer Anwendungsfall, in dem Kubernetes eine ausgezeichnete Wahl ist – wie bereits am Beispiel von Airbnb in diesem Artikel gezeigt wurde.

Ein weiterer großer Vorteil von Kubernetes ist die Anbieter-Unabhängigkeit. Da die Konfiguration über YAML-Dateien erfolgt, lässt sich der Cloud-Anbieter flexibel wechseln, um Kosten zu optimieren. Dadurch vermeidet man eine Vendor-Lock-in-Situation, bleibt unabhängig und kann jederzeit die besten Angebote am Markt nutzen. Zusätzlich automatisiert Kubernetes komplexe Betriebsaufgaben und sorgt für eine automatische Wiederherstellung von Containern im Falle eines Ausfalls.

Zertifizierte Entwickler

Günstige Stundensätze

Schneller Einstieg

Höchst günstige Bedingungen

Vertrag mit

EU Unternehmen

Deutsch- und englischsprachige Spezialisten

Wie fängt man mit Kubernetes an?

Zunächst sollte man mit Container-Technologien wie Docker oder Containerd vertraut sein. Da der kleinste Bestandteil von Kubernetes – der Pod – auf Containern basiert, ist es unerlässlich, deren Erstellung und Verwaltung zu beherrschen. Zudem sind grundlegende Kenntnisse über Serververwaltung, sowohl für virtuelle als auch physische Maschinen, erforderlich. Kubernetes nimmt zwar viele operative Aufgaben ab, doch ein gewisses Verständnis der Infrastruktur ist notwendig, um es effizient zu nutzen.

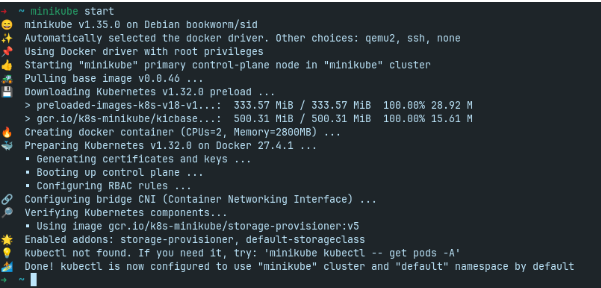

Nun wollen wir ein einfaches Beispiel mit Kubernetes durchspielen. Für lokale Tests gibt es einige CLI-Tools, wobei wir Minikube verwenden, da es am einfachsten ist. Bevor wir starten, müssen Docker, Minikube, kubectl und KVM korrekt installiert und funktionsfähig sein. Anschließend folgen ein paar schnelle Schritte, um eine Instanz zu starten:

- Erstellen Sie ein Minikube-Cluster mit dem Befehl minikube start

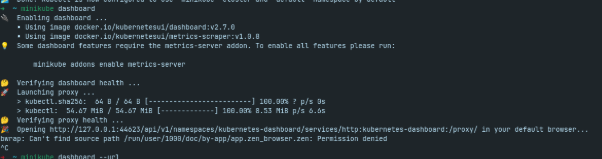

Dadurch wird der Dienst gestartet und ermöglicht die Verwendung der kubectl-Befehle – dem K8S-Dienst, der auf Ihrem Rechner läuft. Hier ist die erwartete Ausgabe:

- Starten Sie das Dashboard mit dem Befehl minikube dashboard.

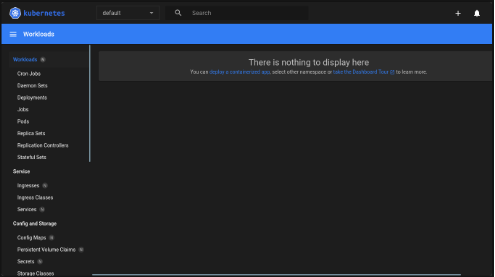

Dadurch wird auf Ihrem Computer ein Server erstellt, der die Kubernetes-Instanz verwaltet und eine Benutzeroberfläche bereitstellt, um die Bedienung zu erleichtern. Hier sind die Konsolenausgabe und die Benutzeroberfläche:

In meinem Fall wurde Zen Browser vom System nicht erkannt. Ich musste jedoch nur die Steuerungstaste gedrückt halten und auf die URL (https://127.0.0.1:44623…) klicken, um die Seite zu öffnen.

- Ein Beispiel-Deployment erstellen

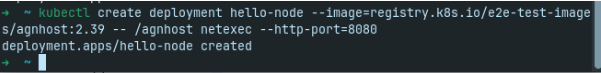

Ein Deployment ist ein Dienst, der den Status Ihrer Pods überwacht und sie im Fehlerfall neu startet. In diesem Beispiel werden wir das Deployment nicht über das Dashboard erstellen. Stattdessen öffnen wir ein neues Terminal und führen folgenden Befehl aus:

kubectl create deployment hello-node –image=registry.k8s.io/e2e-test-images/agnhost:2.39 — /agnhost netexec –http-port=8080

Folgende Ergebnisse sind zu erwarten:

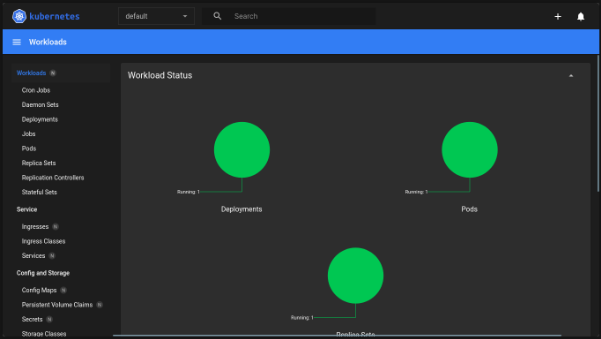

Nun sehen wir im Dashboard, dass der Pod läuft:

Wenn Sie mehr über die Funktionsweise erfahren möchten, können Sie die offizielle Kubernetes-Dokumentation durchsehen. Sie ist wirklich gut geschrieben und die Website ist einfach und übersichtlich gestaltet – so sollten Sie alles finden, was Sie brauchen.

Fazit

Kubernetes ist ein äußerst leistungsfähiges Tool, das Ihnen zehntausende Dollar an Cloud-Kosten sparen kann. Es automatisiert viele kritische Aufgaben, darunter das automatische Skalieren von Services und die Wiederherstellung nach Ausfällen. Zudem kann es komplexe Betriebsabläufe auf Ihren Servern ausführen. Kubernetes kann schnell zum Rückgrat Ihrer Cloud-Infrastruktur werden – allerdings mit einem Preis: Es erhöht die Komplexität Ihrer Anwendungen und lohnt sich nicht in jedem Fall. Wenn Ihr Projekt klein ist, passt Kubernetes vermutlich nicht voll und ganz.

Falls Ihre Anwendung jedoch in dieses Anforderungsprofil passt, können Sie uns bei Chudovo kontaktieren. Klicken Sie hier, um Unterstützung bei der Implementierung von Kubernetes in Ihrem Server zu erhalten. Wir sind ein Beratungsunternehmen mit über 10 Jahren Erfahrung in der Entwicklung von Cloud-Servern, Verwalten von DevOps-Workflows und mehr als 40 festangestellten Experten. Wir helfen Ihnen, diese leistungsstarke Technologie zu implementieren, Ihre Systeme robuster und automatisierter zu gestalten und Ihre Cloud-Kosten erheblich zu senken.