KI-Coding-Assistenten im Vergleich: Copilot vs. ChatGPT vs. Claude

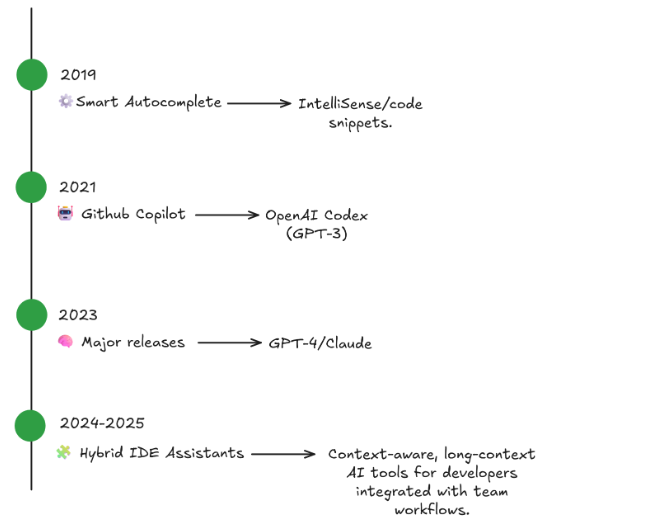

Früher waren Autovervollständigungsfunktionen in IDEs vor allem dazu gedacht, Tippaufwand bei Entwicklern zu reduzieren. Sie haben Wörter basierend auf dem vorhandenen Code vorgeschlagen und kurze Bausteine für Standardcode bereitgestellt.

Heute haben sich diese Lösungen zu vollständigen KI-Programmierassistenten entwickelt, die zahlreiche Aufgaben übernehmen können – vom Lesen und Schreiben bis hin zu konzeptionellen Überlegungen von Code. Entwickler und Engineering Manager bekommen dank solchen KI-Werkzeugen deutliche Produktivitätsgewinne, jedoch funktionieren nicht alle Tools gleich.

In diesem Beitrag vergleichen wir KI-Assistenten, ihre Stärken und Schwächen und zeigen, wofür sie sich im Entwicklungsalltag eignen und wo ihre Grenzen liegen. Vor allem betrachten wie drei der derzeit verbreitetsten Tools:

- GitHub Copilot

- ChatGPT für Code

- Claude für Entwickler

Ziel ist jedoch nicht, einen Sieger zu bestimmen, sondern herauszufinden, welcher KI-Tool für welchen Arbeitsablauf am besten passt.

Der Aufstieg der Code-Assistenten

Große Sprachmodelle (Large Language Models, LLMs) haben in vielen Bereichen an Bedeutung gewonnen, vor allem durch ihre Fähigkeit, mit Menschen in natürlicher Sprache zu interagieren.

Gleichzeitig wird dieses Wissen durch KI-Werkzeuge für Entwickler verwendet, um menschliche Absichten in Code zu übertragen, Fehler zu finden oder Pull Requests zu bewerten. Mit der Einführung von Autovervollständigungsmodellen wie GPT-3 oder GitHub Copilot wurden solche Lösungen weithin bekannt. Die aktuellen Modelle – etwa GPT-5 oder Claude Sonnet 4.5 – basieren auf ähnlichen Grundprinzipien, haben deren Einsatzmöglichkeiten aber erheblich erweitert.

Dank diesen Modellen ist es heute möglich, nicht nur über Tastatureingaben zu arbeiten, sondern über echte Dialoge. Anstatt „tippen, bis es funktioniert“, können Teams ihre Absicht beschreiben und den Assistenten Struktur, Stil und Dokumentation erzeugen lassen.

GitHub Copilot

Der erste Assistent in unserer Liste ist GitHub Copilot, ein Tool, das die tägliche Arbeit von Millionen von Entwicklerinnen und Entwicklern grundlegend verändert hat. Zunächst von OpenAI Codex unterstützt und heute auf GPT-5 mini basierend, integriert sich GitHub Copilot nahtlos in populäre Entwicklungsumgebungen wie JetBrains IDEA, VS Code und sogar Neovim. Weitere Modelle lassen sich über die Benutzereinstellungen auswählen.

Zu den zentralen Funktionen von Copilot gehören:

- automatische Codevervollständigung in Echtzeit

- funktioniert eigenständig, ohne explizite Prompts zu brauchen

- Passt sehr gut für wiederkehrende Logik und Utility-Code

- liefert qualitative Ergebnisse in typisierten Sprachen (z. B. Go, TypeScript)

Hier ein Beispiel für eine TypeScript-Zeile, die Copilot vollständig selbst generiert:

// User types:

function formatDate(date) {

// Copilot suggests:

return date.toISOString().split('T')[0];

}Bei näherem Blick auf die Grenzen von Copilot fällt vor allem auf, dass der Kontext auf die aktuelle Datei oder geöffnete Tabs beschränkt ist. Dadurch fehlt dem Modell die Fähigkeit, über Module oder Architekturen hinweg zu „denken“. Außerdem liefert Copilot nur sehr knappe Erklärungen dafür, warum ein bestimmter Codevorschlag erzeugt wurde.

Allerdings können Nutzer ein separates Chatfenster öffnen, in dem zusätzliche Funktionen wie die Modi Ask, Agent und Edit zur Verfügung stehen. Auf diese Weise lässt sich ein Teil der genannten Einschränkungen umgehen, da man das Modell außerhalb der Datei nutzt – also nicht über die Autovervollständigung.

Aus der Sicht eines KI-unterstützten Entwicklungsalltags glänzt GitHub Copilot vor allem in der Mikroproduktivität: weniger Tippaufwand, weniger Wiederholungen und ein schnellerer Umgang mit Boilerplate-Code. Für Bugfixing oder das Durchdenken komplexer Systemarchitekturen, die über eine einzelne Datei hinausgehen, ist Copilot hingegen weniger hilfreich.

Manager Insight: Laut dem GitHub Octoverse 2025 Report waren die KI-gestützten Geschäftslösungen in der Softwareentwicklung ein entscheidender Faktor für die außergewöhnlich hohe Produktivität in diesem Jahr.

ChatGPT für das Programmieren

Im Gegensatz zu einem Autovervollständigungstool in der IDE eröffnet ChatGPT einen breiten, dialogorientierten Arbeitsraum. Basierend auf GPT-5 bietet ChatGPT viel mehr als Inline-Vorschläge: Es dient zugleich als Lernhilfe, Debugging-Partner und Werkzeug für technische Exploration.

Da ChatGPT in einem vollwertigen Chatfenster läuft, eignet es sich zum Erklären von Legacy-Code, Analysieren von Stack Traces, Fehlerbehebung, Erstellen von Dokumentation sowie zum Abstimmen oder Durchdenken von Architekturmustern, bevor sie umgesetzt werden.

Der Kontext ist dabei nicht auf die aktuelle Datei beschränkt. ChatGPT kann komplette Dateien oder Frameworks bearbeiten, was es sehr praktisch für Fehlersuche und Wissensvermittlung macht. Obwohl der Chat außerhalb der IDE liegt, gibt es eine offizielle Erweiterung, die direkt ins Arbeitsumfeld integriert werden kann.

Trotz dieser Vorteile ist zu beachten, dass Antworten manchmal zu ausführlich oder für anspruchsvolle Probleme zu oberflächlich sein können. Daher ist gutes Prompt-Design hilfreich, um optimale Ergebnisse zu erzielen. Gleichzeitig bietet ChatGPT eine effektive Lernumgebung für neue Teammitglieder oder für Teams, die mit völlig unbekannten Technologien arbeiten.

Claude für Entwickler

Das letzte Tool in unserem Vergleich ist zugleich das jüngste. Claude ist zwar später auf den Markt gekommen, hat aber mit seinem außergewöhnlich großen Kontextfenster überrascht. Das Modell kann bis zu 200.000 Tokens verarbeiten (in manchen Fällen sogar mehr). Dadurch passt es hervorragend zur Analyse ganzer Repositories oder umfangreicher Dokumentationen in einem Durchlauf.

Dank dieser Fähigkeit, mehrere Dateien gemeinsam zu erfassen und zu analysieren, liefert Claude ausgewogene, klare Antworten mit wenig Fülltext. Es wird zudem dafür geschätzt, große Codebasen „intentionsbasiert“ zu verstehen.

Mit einem einzigen Prompt wie: “Prüfe diesen Pull-Request und liste doppelte Logik sowie unnötige Änderungen auf” fasst Claude das Ergebnis zusammen, weist auf doppelte Bedingungen hin und gibt konkrete Hinweise zur Überarbeitung zurück. In gewisser Weise übernimmt es einen Großteil des Code-Review-Prozesses.

Zu den Schwächen von Claude gehört, dass die Leistung bei sehr großen Projekten nachlassen kann. Außerdem kann der Code nicht direkt ausgeführt werden, was schnelle Tests verhindert. Trotzdem verbessert Claude mit seinem Langzeitkontext die Dokumentation, reduziert potenzielle Merge-Konflikte und unterstützt konsistente Stilrichtlinien. Damit ist es ein wertvoller Assistent für den täglichen Entwicklungsprozess.

Produktivität

Der Einsatz von KI-Codeassistenten ist nicht nur ein Trend, er hat die Arbeitsweise erheblich beeinflusst. Unabhängige Studien und Umfragen, darunter GitHub Octoverse 2025 und Stack Overflow Pulse, zeigen, dass Entwickler ihre Produktivität durch KI-Werkzeuge als deutlich gesteigert empfinden.

Allerdings funktionieren die Modelle nicht alle gleich. Verschiedene Benchmarks vergleichen ihre Leistungen und fassen die Ergebnisse übersichtlich zusammen. MArena sieht GPT-5 bei webbezogenen Aufgaben auf Platz 1, gefolgt von Claude Opus 4.1. Ähnliche Ergebnisse liefert DesignArena.

Ein wichtiges Thema für Entwicklungsteams ist die Frage, wie gut sich ein KI-Tool in bestehende Arbeitsumgebungen einfügt. Copilot bietet eine tiefe IDE-Integration, während ChatGPT und Claude sowohl über das Web als auch über IDE-Erweiterungen oder ihre APIs genutzt werden können.

Zusammengefasst: GitHub Copilot beschleunigt das Schreiben von Code, ChatGPT überzeugt beim Debugging und Mentoring, und Claude liefert starke Ergebnisse beim Refactoring und in Code-Reviews.

Zudem lässt sich ein Trend der Einstellung von Software-Entwickler mit dem mit Know-how im Bereich KI-gestützter Entwicklung beobachten.

Kosten

Das Copilot-Abo beginnt bei 10 US-Dollar für Einzelpersonen und 19 US-Dollar für Unternehmen. Das ChatGPT-Plus-Abo kostet 20 US-Dollar, während der Business-Plan 25 US-Dollar pro Nutzer kostet. Claudes Pro-Abo startet bei 17 US-Dollar für Einzelpersonen, und der Preis für den Enterprise-Plan beginnt bei 25 US-Dollar.

Die unterschiedlichen Preismodelle können beeinflussen, wie attraktiv die Tools für Entwickler oder Unternehmen sind. Bei der Kostenanalyse ist es außerdem wichtig, den möglichen ROI zu berücksichtigen, den jeder Assistent liefern kann.

Datenschutz

Der Einsatz eines KI-Programmierassistenten erfordert oft das Teilen sensibler Informationen: Code, Geschäftslogik, proprietäre Daten usw. Um Sicherheitsrisiken oder Datenlecks zu vermeiden, sollte klar definiert sein, ob und wie die Modelle oder ihre Anbieter auf diese Informationen zugreifen.

Je nach Anbieter unterscheidet sich der Zugriff auf Daten. Grundsätzlich verfolgen die drei hier verglichenen Tools unterschiedliche Richtlinien für Privatnutzer und Geschäftskunden. GitHub Copilot sammelt beispielsweise Code-Snippets zur Produktanalyse – ausgenommen sind dabei private Repositories von Nutzern der Copilot-Business- oder Enterprise-Pläne.

OpenAI nutzt die Daten von Privatnutzer*innen zum Training seiner Modelle, bietet jedoch eine Opt-out-Möglichkeit. Eine Ausnahme bilden Informationen, die über explizites Feedback gesendet werden (z. B. Daumen hoch/runter. Diese Daten werden immer gesammelt und zur Verbesserung der Modelle verwendet. Zudem werden temporäre Chats weder gespeichert noch fürs Training genutzt.

Bei Geschäftskunden gilt: OpenAI nutzt die Daten nur, wenn der Nutzer dem ausdrücklich zugestimmt hat.

Claude setzt stark auf Datenschutz und Datensicherheit. Nutzer können dem Modell erlauben, ihre Daten zu verwenden. Diese Regel gilt jedoch nicht für Informationen, die im Rahmen von explizitem Feedback übermittelt werden oder wenn eine Unterhaltung zur Sicherheitsüberprüfung markiert wird. Geschäftskunden müssen dem „Development Partner Program“ zustimmen.

Wer jegliche Weitergabe von Daten an Dritte vermeiden will, sollte eine eigene Bereitstellung in Betracht ziehen, z. B. durch Open-Source-Modelle, die lokal installiert und betrieben werden können. Generative KI-Entwicklung kombinieren solche Modelle mit privaten Cloud-Ressourcen, um die vollständige Datenkontrolle zu behalten.

Eine Aufgabe für drei Assistenten

Um die Unterschiede der drei Tools zu veranschaulichen, betrachten wir ein kurzes Beispiel. Stell dir vor, du arbeitest in einem kleinen Team und musst eine Node.js-API mit Pagination entwickeln. Du kannst alle drei Assistenten aus diesem Beitrag nutzen, das heisst, du gibst jedem einen denselben Prompt:

Schreibe eine Express-Route, die paginierte Ergebnisse aus einer Datenbank liefert.

GitHub Copilot wird wahrscheinlich am schnellsten reagieren. Es beginnt direkt in der aktuellen Datei in deiner IDE zu tippen und erzeugt den benötigten Code, damit ein funktionsfähiger Endpunkt entsteht, der die Daten aus der Datenbank bezieht und an den Client zurückgibt. Bei Bedarf fügt Copilot ein paar hilfreiche Kommentare ein, damit der Ablauf verständlicher wird. Weitere Erklärungen gibt es nicht.

ChatGPT hingegen verarbeitet die Anfrage langsamer. Der Assistent erklärt zuerst, was eine API ist und wie sie funktioniert. Dann folgen gängige Strategien und Best Practices aus der Community. Anschließend erläutert ChatGPT ein Codebeispiel, das die Aufgabe umsetzt. Zum Schluss zeigt es, wie die neue Route aus einer Frontend-Anwendung genutzt wird.

Claude liest den Prompt und analysiert die Anforderung sehr gründlich. Auf dieser Basis gibt es ein vollständiges Beispiel zurück. Es weist auf wichtige Punkte wie Performance, mögliche Kompromisse und sinnvolle Best Practices hin.

Aus der Sicht eines Entwicklers lässt sich sagen: GitHub Copilot bietet die schnellste Umsetzung. ChatGPT vermittelt Grundlagen und Wissen. Claude liefert ein besonders ausgereiftes Ergebnis mit hoher Qualität.

Wichtige Tipps

Damit du KI-Coding-Tools optimal einsetzt, solltest du Folgendes beachten:

- Lerne unterwegs. Führe zuerst ein Tool in einem Team ein, beobachte die Ergebnisse und passe den Einsatz entsprechend an.

- Setze die Grenzen. KI kann wiederholbare Aufgaben übernehmen, Code schreiben, dokumentieren oder Tests erzeugen. Manche Dinge sollten aber Menschen weiterhin steuern.

- Bringe alle auf denselben Wissensstand. Biete kurze Workshops an, wie man gute Prompts schreibt und was KI leisten kann.

- Schütze deine Daten. Entferne sensible Informationen, bevor du externe Services nutzt.

- Bleibe flexibel. Behandle KI-Integration wie jedes andere Experiment: prüfen, anpassen, erneut versuchen.

Viele Agenturen für generative KI-Beratung folgen genau diesem Ansatz.

Fazit

Welcher KI-Coding-Assistent am besten passt, hängt von Teamgröße, Projektumfang und weiteren Faktoren ab.

Für Solo-Entwickler oder Freelancer eignet sich GitHub Copilot gut. Es liefert schnelle Vorschläge und eine leichte Integration, die sich mit dem Chatfenster erweitern lässt. Für Startups oder größere Engineering-Teams passen ChatGPT und/oder Claude. Beide bieten ein tiefes Verständnis langer Kontexte, Dokumentation, Review-Automatisierung, vielseitiges Debugging und Unterstützung bei Architekturentscheidungen.

Organisationen mit hohen Datenschutzanforderungen sollten ein privates LLM-Setup in Betracht ziehen, um volle Kontrolle mit einem Open-Source- oder maßgeschneiderten Modell zu behalten.

Vor einer endgültigen Entscheidung hilft es, die Tools einzeln zu testen und Kennzahlen zu vergleichen: die durchschnittliche Zeit von einem gemeldeten Bug bis zur Lösung, die Dauer von Reviews und die Vollständigkeit der Dokumentation.

Statt Copilot, ChatGPT und Claude gegeneinander zu vergleichen, nutze jedes Tool für das, was es am besten kann. Wenn du eine extrem schnelle Coding-Assistenz brauchst, wähle Copilot. Es erzeugt Code, so schnell du denken kannst.Wenn du die Erklärung bei komplexen Themen brauchst, kann ChatGPT ausführliche Antworten liefern.Claude prüft alles sehr gründlich, entdeckt mögliche Verbesserungen oder versteckte Fehler, bevor etwas ausgeliefert wird.